撰文 | 塞萨尔·伊达尔戈(César A。 Hidalgo)

翻译 | 魏书豪

审校 | 孙琳钰、clefable

在人工智能(AI)技术还没火之前,计算机科学家亨利·利伯曼(Henry Lieberman)曾邀请我去麻省理工学院参观他的实验室。亨利痴迷于“AI缺乏常识”这个观点。为此,他与同事凯瑟琳·豪沃希(Catherine Havasi)和罗宾·斯皮尔(Robyn Speer)一直在网络上收集常识性内容,来分析人类对常识的理解和推理过程,期望找到增强AI通识能力的方法。

人们习惯评判好坏

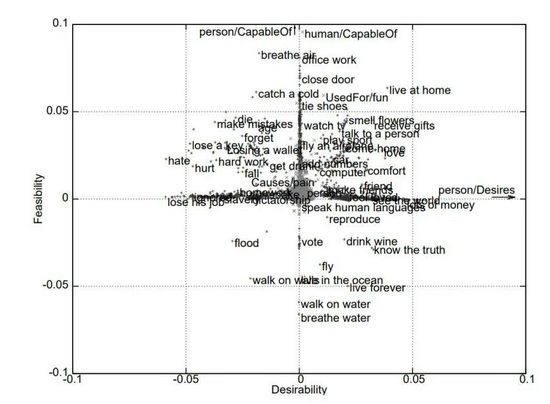

诸如“水(和雨都)是湿的”或“爱(和恨都)是一种感觉”之类的常识,对人类来说显而易见,但机器却难以掌握。这也是人工智能的一个难点,学者们仍在试图理解,为什么理解常识对机器而言如此困难。那天,亨利激动地向我展示了一张图表。他们通过主成分分析(PCA)的方法,将收集的常识性词语集进行多维度的分析和压缩,将最终得出两个最能差异化区分所有词语的维度,设置为了横轴和纵轴,“爱”、“水”和“感觉”之类的词就散布在这张图上。

亨利说:“用PCA来分析常识性的认知,就像是用数学方法试图回答一个古老的哲学问题:人类的知识到底是关于什么的?”我问他这些轴都代表什么含义,卖完关子后,亨利揭晓了答案:最能区分常识性概念的第一个维度,是好与坏。

事后看来,这个规律似乎显而易见。我们每天都会在认知事物和交流沟通中进行无数的好坏评判。我们说天气有“好”和“坏”。我们要寻找更“好”的工作。我们喜欢“好”的音乐,不喝“坏”的酒。然而,人们尚能理性地看待某人袜子上有个洞无伤大雅,跟他的道德无关,但我们却常常在语言中忍不住滥用道德批判。亨利的图表证明了人类语言中普遍存在着好坏评判,这种道德评判也隐含在常识性知识的理解和推理中。

AI犯错,难以原谅?

如今,AI和开发它的人会遭受很多批评。人们愤怒往往是有道理的。AI曾经陷入多起科技丑闻,比如给照片分类时出错,面部识别出错导致无辜的人被捕,或者在评估再次犯罪时具有明显的偏见,以及翻译中存在与性别相关的刻板语句。在大多数情况下,AI界的研究人员都会倾听群众的意见。时至今日,研究人员已经很清楚AI的这些问题,并在积极努力地解决。

随着激烈的争论渐渐过去,值得思考的不仅是AI是“好”还是“坏”,还有批判AI失误时人们展现出来的道德。毕竟,AI伦理也是人类制定的,我们才能做出判断。

在过去的一段时间里,我和我的团队一起做了几十个实验。在这些,我们招募了几千名受试者,要求他们在实验中对人类和AI的行为做出反应。这些实验包括一些场景,如人类或机器使用挖掘机不小心挖开了一个坟墓,或者监视着海啸预警系统,却未能及时向沿海城镇发出警报。这样的比较使我们能够超越单纯由人评判AI的局限,去观察人们在判断机器和人类行为时有什么区别。

这种差异看似微妙,但它迫使我们用一个更现实的参照标准来评判机器行为。过去,我们倾向于用一个完美的标准来衡量AI,而没有对比过如果人类发生同样行为,造成相同的后果后,大家是如何反应的。那么,这些实验告诉了我们什么?

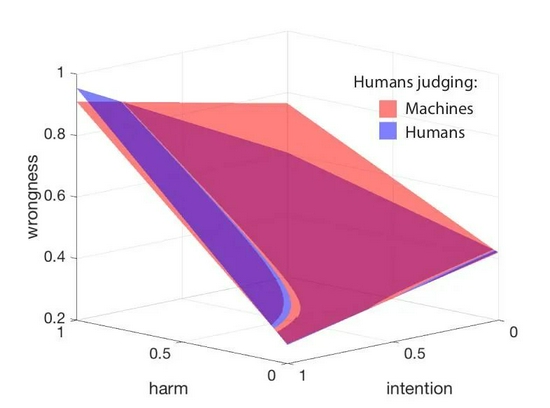

论迹不论心

早期的数据已经清晰地表明,人类对人和机器行为的反应并不相同。例如,在发生意外时,人们对AI的宽容度要低于人类,尤其是当AI造成实质性伤害时。基于几千个数据点,我们可以更深入地研究这些问题,通过建立一个统计模型来解释人们是如何评判人类和机器的。该模型成功预测了人们如何根据造成的伤害以及错误方的“故意程度”打分。

令我们惊讶的是,该模型表明,人们对人类的道德批判并不比对AI更轻,只不过我们使用了不同类型的道德要求来评判二者。下面的这张图总结了这一发现,蓝色和红色平面分别显示了人们如何评判其他人和机器的行为(平均值)。

你可以清楚地看到,平面是不平行的,红色和蓝色平面之间存在偏移。这是因为,在评判机器时,人们似乎更关心事件的结果,即事件带来的伤害程度。这就是为什么红色平面几乎完全沿着伤害维度增长的原因。但是当人们评判他人时,我们在蓝色平面发现了一个曲率。这一次,增长是沿着伤害和意图(故意程度)平面的对角线上升的。这就解释了为什么在发生意外的情况下,人们对机器的评判更加严厉;人们采用结果主义的方法来评判机器,意图无关紧要,但评判人类时则不是这样。

这个简单的模型让我们得出了一个有趣的结论,人们会基于一个经验原则来评判机器与人类的行为,简而言之就是:“人们根据动机评判人类,根据结果评判机器。”

常见的“双标”

但这些实验对我们认识人们的道德直觉有什么启示呢?首先,这些实验告诉我们,人们的道德理念并非固定不变。我们可能会告诉自己,我们是有原则的人,但事实是,我们的判断常会根据判断的人或事物而发生变化(简称双标)。这种摇摆不定的道德标准,并不仅局限于评判人类和机器行为时。

我们在道德上摇摆不定,或并非因为偏袒某一群体那么简单。如果人们只支持人类而不是机器,那么红色和蓝色平面就会平行,但结果却并非如此。这意味着人们不是只喜欢人类而不喜欢机器,只是我们对人和机器的判断不同。相比于用结果主义道德评判机器,我们对人类同胞有着讲道义或更康德式的道德评判标准。

但最重要的一点可能是,我们能通过训练机器的技术来了解人类的道德。在我的研究中,我们通过建立一个简单的,多维度的道德评判模型来了解人类道德的好恶。在亨利等人的研究中,他们通过流行的“降维技术”分析和了解了人类常识中的道德。

在告诉我第一个维度是“好与坏”之后,亨利让我猜第二个轴代表了什么。“易与难,”他说,“简单地说,所有的常识知识都是关于什么是‘好’的或者‘坏’的,以及什么是‘容易’的或‘困难’的。其余的都不重要。”

原文链接:

https://www.scientificamerican.com/article/why-we-forgive-humans-more-readily-than-machines/

相关文章